Programmierbare Ethik?

15.01.2019Die Austauschplattform „Philosophie trifft“ geht in die zweite Runde: Am Montag, 21. Januar 2019, laden die Organisatoren zur Podiumsdiskussion in die Residenz ein. Diesmal lautet das Thema „Ist Ethik programmierbar?“.

Philosophie und Informatik zusammenbringen: Das ist eines der Ziele einer neuen Veranstaltungsreihe an der Universität Würzburg, die im Dezember 2018 gestartet wurde. Jetzt steht der zweite Termin an: Am Montag, 21. Januar, werden die Professoren Jörn Müller (Philosophie), Tobias Hoßfeld (Informatik) und Lukas Worschech (Physik) die Frage „Ist Ethik programmierbar?“ kritisch betrachten und gemeinsam mit dem Publikum nach Antworten suchen.

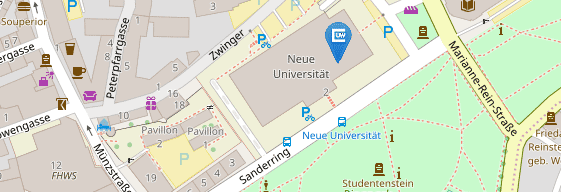

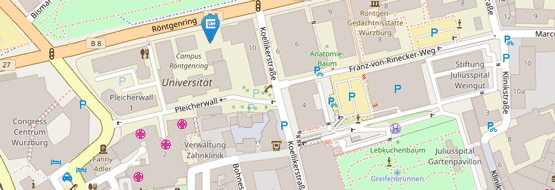

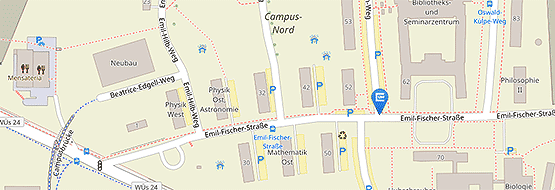

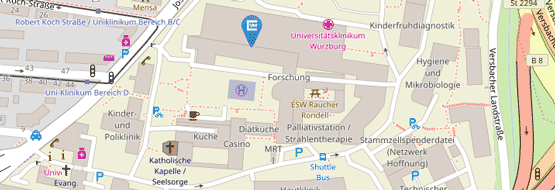

Die Veranstaltung richtet sich an Studierende, Forschende, Vertreter aus Unternehmen der Region Mainfranken und alle Interessierte. Sie findet statt im Toscanasaal im Südflügel der Würzburger Residenz. Beginn ist um 20.00 Uhr; der Eintritt ist frei.

Künstliche Intelligenz und moralische Normen

Zum Hintergrund: Ist es eine Utopie, dass eine der größten Erfindungen unserer Zeit – die Künstliche Intelligenz – die Frage „Ist Ethik programmierbar?“ mit einem „Ja“ beantworten wird?

Ohne Künstliche Intelligenz (KI) kann man die moralischen Normen der Gesellschaft mit vielfachen Wenn-Dann-Sonst-Verzweigungen vielleicht kurzweilig abbilden. Aber die Normen sind im Wandel und auch kulturell bedingt. Und jede Norm ist je nach Situation zumeist nur graduell anwendbar. Außerdem existieren verschiedene Paradigmen, die für die Moral-Waage jeweils ihre eigenen Etalons verwenden wie zum Beispiel das Glück, das Mitleid oder die Menschenwürde.

Die Mitte zwischen zwei Extremen

Aber was sind Glück, Mitleid, Menschenwürde – hier gibt es bereits verschiedene Ansichten. Unter anderem dadurch sind die Normen schon für uns Menschen und erst recht für die Maschinen nicht einfach erlernbar. Normen sind nicht immer allgemein logisch und können sich auch widersprechen. Aristoteles etwa beschreibt in seiner Nikomachischen Ethik die Schwierigkeit, in jeder neuen Situation die Mitte zwischen zwei Extremen zu treffen – die Mesotes. Die Mesotes ist weder eine arithmetische noch eine goldene Mitte. Sie ist selbst ein Extrem, denn sie soll absolut exakt getroffen werden. Die Mesotes beispielsweise zwischen den zwei Extremen „Feigheit“ und „Tollkühnheit“ zu der Tugend „Tapferkeit“ ist allgemein näher an der Tollkühnheit, aber je nach Situation erfordert es die Mesotes immer wieder neu (und exakt!) zu treffen. Erlernt werden die Tugenden, wie Tapferkeit oder Mäßigung, laut Aristoteles durch die Erziehung, damit das exakte Treffen der Mesotes zum Habitus wird.

Kann Künstliche Intelligenz Neues schaffen?

Der Glaube an die KI fundiert unter anderem in dem Glauben an die Allwissenheit, die der natürlichen Intelligenz nicht zugetraut wird. Führt denn die (vermeintliche) Allwissenheit automatisch zur Allgerechtigkeit? Beginnt für manch einen hier die Hoffnung der Verkupplung der Alles-Programmierbarkeit mit der Allwissenheit? Die KI müsste doch „nur“ X lernen und dann kann sie schon dieses X. Zum Beispiel muss die KI nur Gemälde „anschauen“ und dann kann sie schon selbst malen. Die KI muss „nur“ im Auto viel mitfahren und dann kann sie schon selbst fahren. Die KI muss „nur“ kochen lernen und dann kann sie schon selbst kochen. Aber kann die KI dann neue Kunstrichtungen einschlagen und neue Verkehrsregeln ohne weiteres anwenden? Oder kurz: Kann die KI Neues schaffen? Auch wenn der Entwickler die Rahmenbedingungen beim intelligenten Lernen vorgibt, lernt die KI vielleicht doch nur die Muster der IST-Zustände in einem sehr spezifischen Bereich zu erkennen. Würden dann solche smarte Algorithmen uns nicht dazu verleiten nach ihren Mustern zu leben?

Kontakt

Stanislav Pilischenko, Servicezentrum Forschung und Technologietransfer, T +49 931 31-81752, stanislav.pilischenko@uni-wuerzburg.de