Dialog mit dem Computer

20.12.2022Goran Glavaš ist neuer Professor am Institut für Informatik der Universität Würzburg. An seinem Lehrstuhl forscht er daran, wie die Verarbeitung natürlicher Sprache fairer und ressourcenschonender gestaltet werden kann.

Damit Computer in der Lage sind, menschliche Sprache zu verstehen und mit Menschen zu kommunizieren, werden sie mit gewaltigen Mengen an Texten gefüttert und daran trainiert. Bei Sprachen wie Englisch, Spanisch oder Chinesisch ist das kein Problem: Für sie finden sich im Internet Quellen in ausreichender Menge. Aber wie sieht das für Sprachen wie etwa Kroatisch oder Suaheli aus? Da wird das Datenfundament schon deutlich dünner – mit der Folge, dass diese Sprachen beziehungsweise Länder kaum oder gar nicht berücksichtigt werden, wenn Tech-Giganten wie Google, Meta oder Microsoft ihre Forschung im Bereich des Natural Language Processing vorantreiben.

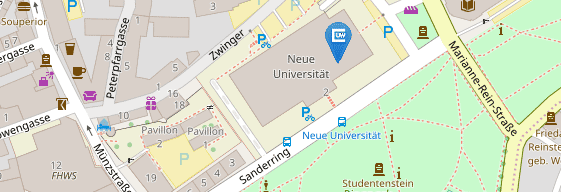

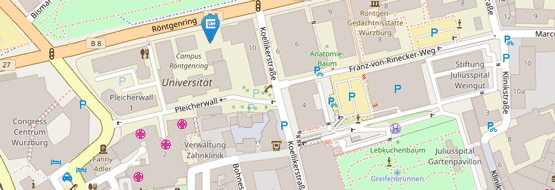

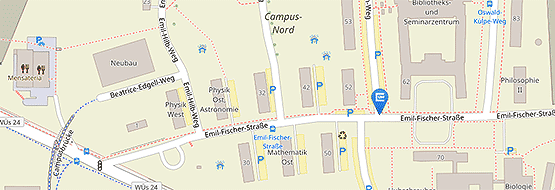

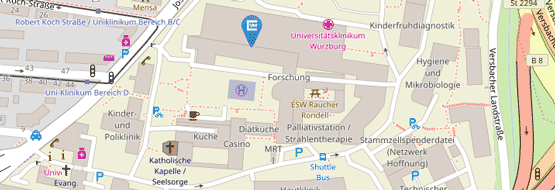

„Ungerecht“ findet Goran Glavaš dieses Phänomen. Mit seiner Forschung will er deshalb daran mitwirken, solche und andere Ungerechtigkeiten zu beseitigen. Glavaš hat seit dem Sommer 2022 den Lehrstuhl für Informatik XII an der Julius-Maximilians-Universität Würzburg inne. Natural Language Processing (NLP) beziehungsweise die Verarbeitung natürlicher Sprache bildet dort einen Schwerpunkt.

Erhebliche Fortschritte in der Sprachverarbeitung

„Angetrieben von den Fortschritten beim Deep Learning hat NLP in den vergangenen Jahren erhebliche Fortschritte gemacht. Vor allem dank besserer technischer Möglichkeit ist es heute möglich, immer größere neuronale Modelle auf immer mehr Text zu trainieren“, erklärt Glavaš. Und somit können heutzutage eben viele Menschen in Europa und den USA ganz selbstverständlich Alexa oder Siri mündlich Aufträge erteilen, die diese fehlerfrei umsetzen.

Das Problem dabei: „Ein solcher Fortschritt kann exklusiv sein, da seine Vorteile für den Großteil der Weltbevölkerung unerreichbar sind“, sagt der Informatiker. Wer also eine Sprache spricht, die nur ein kleiner Teil der Bevölkerung verwendet, wird von diesen Fortschritten nicht profitieren – genauso wenig wie Bevölkerungsgruppen, die nicht über die erforderlichen Computerressourcen verfügen, die man braucht, um die Rechner mit den entsprechenden Modellen zu trainieren.

Mit der Technik sind etliche Nachteile verbunden

Dass die technische Entwicklung „große“ Sprachen bevorzugt, ist allerdings nicht das einzige Problem hinter dieser Technik. Für Goran Glavaš sind damit aktuell noch zwei weitere gravierende Nachteile verbunden. Zum einen: „Das Training immer größerer Sprachmodelle auf der Grundlage komplexer neuronaler Architekturen hinterlässt einen großen ökologischen Fußabdruck“, sagt er. Soll heißen: Diese Technik verbraucht gewaltige Mengen an Energie und ist somit für einen gewaltigen Ausstoß an klimaschädlichem CO2 verantwortlich.

Und zum anderen: „Solche Modelle neigen dazu, ein breites Spektrum negativer gesellschaftlicher Stereotypen und Vorurteile wie beispielsweise Sexismus oder Rassismus zu kodieren“, erklärt Glavaš. Der Grund dafür liegt auf der Hand: Damit Texte von Computern gelesen und verstanden werden können, müssen diese zunächst von Menschen „annotiert“ werden – also mit Anmerkungen versehen, die erklären, worum es sich jeweils handelt. Weil Menschen aber oftmals Vorurteile mit sich herumtragen, bleibe es nicht aus, dass diese Vorurteile von den Spracherkennungsprogrammen übernommen werden.

Ziel: die Technologie gerechter machen

Drei Ziele hat sich Goran Glavaš deshalb für seine Forschung an der JMU gesetzt: Er will zum einen nachhaltige und modular aufgebaute Modelle entwickeln, die weniger Rechenleistung benötigen, dadurch ressourcenschonender arbeiten und auch von kleineren Einheiten verwendet werden können als beispielsweise Google sie sich leisten kann. Zum zweiten sollen diese Modelle fair and ethisch korrekt arbeiten – also möglichst vorurteilsfrei. Und zum dritten sollen diese Modelle dazu in der Lage sein, die Fähigkeiten, die sie sich zum Beispiel an englischsprachigen Textsammlungen antrainiert haben, auf andere Sprachen zu übertragen.

Auf einen Nenner gebracht, könnte Goran Glavaš‘ Ziel also lauten: die Technologie des Natural Language Processings gerechter machen. Unter anderem deshalb habe er sich dafür entschieden, an der Universität zu bleiben und nicht bei einem Technologie-Unternehmen anzuheuern.

Zur Person

Goran Glavaš (36) hat von 2005 bis 2010 an der Universität Zagreb (Kroatien) Informatik studiert und mit dem Master abgeschlossen. 2014 wurde er dort mit einer Arbeit über „Information Extraction and Retrieval Based on Event Graphs“ promoviert. Von Mai 2014 bis September 2015 forschte er als Postdoc am TakeLab der Universität Zagreb, von Oktober 2015 bis August 2017 in der Data and Web Science Group der Universität Mannheim.

Von 2017 bis 2021 war Glavaš Juniorprofessor für Statistische Maschinelle Sprachverarbeitung und Textanalyse für interdisziplinäre Forschung an der Universität Mannheim, von 2021 bis 2022 Vertretungsprofessor am Center for Information and Language Processing der LMU München. Seit dem 1. April 2022 hat er an der Universität Würzburg den Lehrstuhl für Informatik XII (Natural Language Processing) inne.

Kontakt

Prof. Dr. Goran Glavaš, Institut für Informatik, T: +49 931 81352, goran.glavas@uni-wuerzburg.de